1.可视化部署

偶数云平台 skylab

magama 安装 - skylab 节点管理(需要 sudo 免密) - 安装 oushuDB 基础服务(集群模式需要安装 Nginx 负载均衡)- 云数据库 oushuDB 工作簿 校验服务状态 - oushuDB 新建集群 计算节点/存储节点/配置参数 - 部署完成

2.命令行安装

2.1 环境配置

确认集群是否支持 avx 指令集

language cat /proc/cpuinfo | grep avx

设置 yum 源

wget -P /etc/yum.repos.d $获取的repo url

禁用 selinux

sed -i "s/^SELINUX\=enforcing/SELINUC\=disabled/g" /etc/selinux/config

setenforce 0

关闭防火墙

systemctl stop iptables

systemctl disable iptables

systemctl stop firewalled

systemctl disable firewalled

安装 OpenJDK

yum install -y java-1.8.0-openjdk java-1.8.0-openjdk-devel mkdir -p /usr/java

//查看本机java版本

ln -s /usr/lib/jvm/java-1.8.0-openjdk-1.8.0.141-2.b16.e17-4.x86_64 /usr/java/default

2.2 安装 hdfs

# 由于hadoop依赖于特定版本的snappy,先卸载snappy确保安装顺利

yum -y remove snappy

# 安装HDFS PRM,PRM安装会自动创建hdfs用户

yum install -y hadoop hadoop-hdfs

# 在/data1创建NameNode目录

mkdir -p /data1/hdfs/namenode

# 在每块盘上创建DataNode数据目录,并更改权限

mkdir -p /data1/hdfs/datanode

chmod -R 755 /data1/hdfs

chown -R hdfs:hadoop /data1/hdfs

mkdir -p /data2/hdfs/datanode

chmod -R 755 /data2/hdfs

chown -R hdfs:hadoop /data2/hdfs

2.2.1 配置文件修改

hdfs 配置文件获取 - 官网快速安装

core-site.xml

hdfs-site.xml

hadoop-env.sh

复制配置文件到/etc/hadoop/conf

core-site.xml

外部访问url

<property>

<name>fs.defaultFS</name>

<value>hdfs://oushu:9000</value>

</property>

hdfs-site.xml

多快盘配置属性

<property>

<name>dfs.data.dir</name>

<value>/data1/hdfs/datanode,/data2/hdfs/datanode</value>

<final>true</final>

</property>

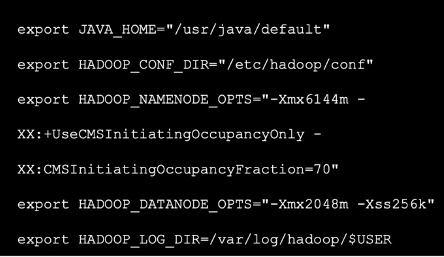

hadoop-env.sh

export JAVA_HOME=${JAVA_HOME}

export HADOOP_CONF_DIR=${HADOOP_CONF_DIR:-"/etc/hadoop"}

export HADOOP_NAMENODE_OPTS="-Dhadoop.security.logger=${HADOOP_SECURITY_LOGGER:-INFO,RFAS} -Dhdfs.audit.logger=${HDFS_AUDIT_LOGGER:-INFO,NullAppender} $HADOOP_NAMENODE_OPTS"

export HADOOP_DATANODE_OPTS="-Dhadoop.security.logger=ERROR,RFAS $HADOOP_DATANODE_OPTS"

export HADOOP_LOG_DIR=${HADOOP_LOG_DIR}/$USER

格式化 namenode,并启动

sudo -u -E hdfs hdfs namenode -format

sudo -u -E /usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh start namenode

sudo -u -E /usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh start datanode

# 检查是否成功运行

su - hdfs

hdfs dfsadmin -report

hdfs dfs -mkdir /testnode

hdfs dfs -put /usr/hdp/current/hadoop-client/sbin/hadoop-damen.sh /testnode/

hdfs dfs -ls -R /

# or

http://hostname:50070/

日志排错

/var/log/hadoop/hdfs

2.3 安装 oushuDB RPM

yum install -y hawq

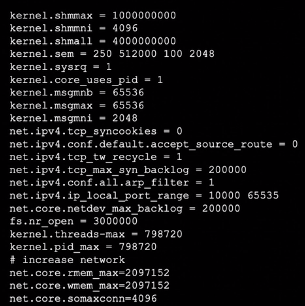

修改配置文件 /etc/sysctl.conf

使系统配置生效

sysctl -p <默认/etc/sysctl.conf>

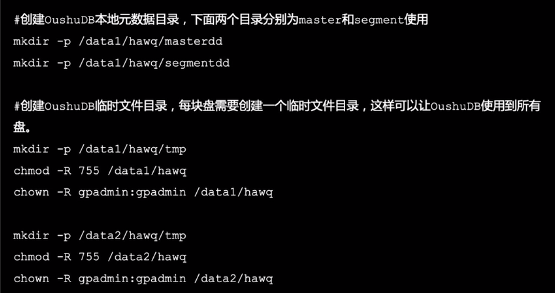

创建本地元数据目录和临时文件目录

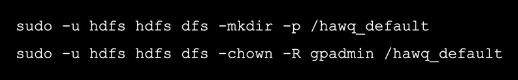

hdfs 创建 oushuDB 数据目录

/usr/local/hawq/etc/slaves

/usr/local/hawq/etc/hawq-site.xml

hawq_master_temp_directory

hawq_segment_temp_directory # 数据盘参数

创建 magma node 数据目录

mkdir -p /data1/hawq/magma_segmentdd

mkdir -p /data2/hawq/magma_segmentdd

chown -R gpadmin:gpadmin /data1/hawq

chown -R gpadmin:gpadmin /data2/hawq

/usr/local/hawq/etc/magma-site.xml

设置免密 SSH

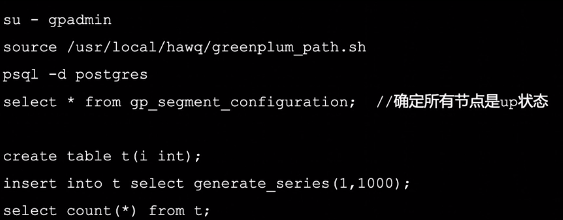

su - gpadmin

source /usr/local/hawq/greenplum_path.sh

hawq ssh-exkeys -h oushu

初始化 oushuDB

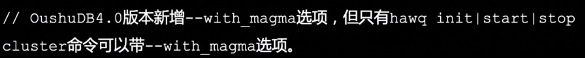

hawq init cluster # oushuDB4.0默认不启动magma服务

hawq init cluster --with_magma # oushuDB4.0新增,3.x版本不支持该选项

oushuDB 管理工具日志

/home/gpadmin/hawqAdminLogs

master日志

/data1/hawq/masterdd/pd_log/

segment日志

/data1/hawq/segmentdd/pd_log/

检查oushuDB是否运行正常